Ne croyez personne: ce qui menace le réseau de neurones, faire du porno

Dmitry Kurkin

Faux vidéos pornodans lequel la vedette du film "Wonder Woman", Gal Gadot qui aurait eu des relations sexuelles avec son demi-frère, qui est apparu sur le Web cette semaine, s'est révélée être non seulement un faux, mais un faux généré par l'intelligence artificielle.

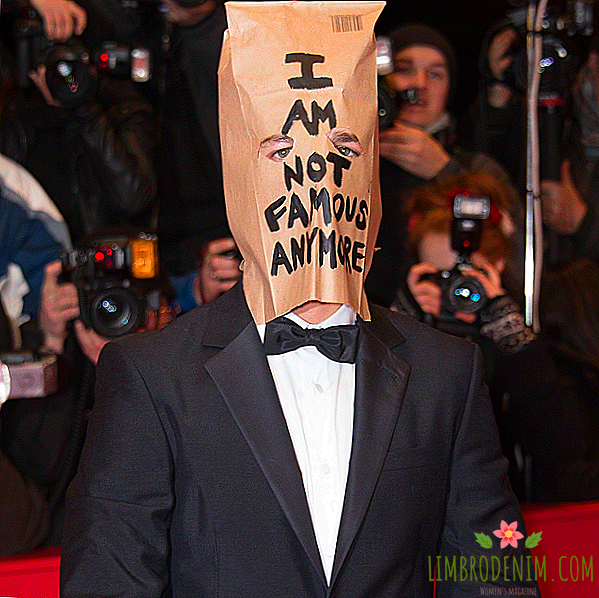

Dans une interview avec Vice, l'auteur de la vidéo, un utilisateur anonyme de Reddit portant le surnom deepfakes, a confirmé qu'il avait utilisé le réseau de neurones pour "prendre en photo" le visage de Gadot sur le corps de l'actrice porno. Le faux, en général, est visible, et le deepfakes ne prévoyait pas de gagner de l'argent dessus - a-t-il dit, il voulait juste vérifier à quel point il serait facile de le fabriquer en utilisant l'IA. Et il a de mauvaises nouvelles pour nous: il était très facile de faire du faux porno à la maison.

Le problème, en général, ne se situe pas dans les pornofeaks eux-mêmes: la demande d'images et de vidéos, où des acteurs et des actrices célèbres, ont des rapports sexuels, a été, est et sera avec les fétichistes et les amateurs de sensations. Sur la similitude externe avec les stars de l'industrie du porno, des carrières entières se profilent - ce phénomène a même provoqué un gros titre de la presse jaune: "Le nain Gordon Ramsay est retrouvé mort dans un trou de blaireau".

Mais si auparavant, la production nécessitait du temps, des ressources et une certaine habileté, un réseau de neurones, formé pour souder des visages à une image, simplifie grandement la tâche. Les robots collent, pas un homme, et les robots deviennent de plus en plus intelligents, ce qui signifie que les contrefaçons auront l'air de plus en plus fiables. L'utilisateur de deepfakes a expliqué qu'il avait collecté son logiciel d'intelligence artificielle à partir d'éléments improvisés trouvés dans les bibliothèques open source, et pris des photos et des vidéos dans des drains publics et hébergés tels que YouTube. En termes simples, tous les outils permettant de générer pornofeikov reposaient sous son nez, non seulement avec lui, mais également parmi des millions de personnes dans le monde.

Et cela, à proprement parler, pas même les nouvelles. En 2003, des experts de la santé et de la science de l’Université d’Oregon ont averti que les fraudes audio étaient «faciles à commettre et difficiles à détecter». En 2017, les prévisions se réalisaient et il existait de faux enregistrements vocaux générés par des réseaux de neurones très difficiles à distinguer des réseaux réels. Après l'audio, la vidéo a été tirée. Le développement du personnel de l'Université de Washington synchronise les expressions faciales du visage d'une personne avec son discours: dans le clip vidéo avec Barack Obama aménagé par exemple, seul le son est présent, l'image est générée par le programme. Connectez l'une à l'autre - et il existe maintenant de fausses vidéos prêtes dans lesquelles un politicien libéral bien connu "avoue" ses sympathies pour Hitler.

Il faut un peu d'imagination pour imaginer à quel point une telle intelligence artificielle peut être utilisée abusivement. Les chatbots de Microsoft, que les trolls de Twitter ont transformés en racistes en moins d'une journée, sembleront être une jolie blague. Et bien sûr, la technologie de pornofeed n'est pas principalement menacée par Gal Gadot, Taylor Swift ou Jennifer Lawrence. Ils sont suffisamment en sécurité pour engager une armée de spécialistes en informatique qui reconnaissent un faux et une flotte d'avocats qui poursuivront en justice quiconque tentera d'utiliser ces faux à des fins personnelles.

Non, les simples mortels seront victimes de nouveaux algorithmes inoffensifs. Les faux numériques peuvent être utilisés pour la pornographie, le harcèlement en ligne, le harcèlement de réseau, le chantage et la manipulation par des personnes facilement suggestibles et qui ne suivent pas particulièrement les nouvelles du domaine des technologies avancées ("Votre fille a été enregistrée sur vidéo, virez de l'argent immédiatement, sinon TOUT sera vu"). Et nous ne parlons pas nécessairement de pornographie: des contrefaçons peuvent également être introduites dans le réseau à des fins de propagande politique et d'incitation à la haine.

"Mais c'est monstrueux!" Oui, monstrueux, et ce n’est pas le codeur deepfakes à blâmer. Alors que les pirates informatiques s'introduisent parfois dans les systèmes bancaires non pas pour voler de l'argent, mais pour pointer le département de la cyberdéfense vers des failles de sécurité, il a été inventé par le programmeur anonyme de l'IA qui nous met au fait: l'ère des contrefaçons numériques n'est pas une histoire d'horreur anti-utopique "Black Mirror", et la réalité à venir. L'éthique moderne ne l'a pas encore comprise (les pornophiles peuvent-ils être considérés comme une atteinte à la vie privée d'autrui?), Pas plus que la loi en vigueur. Mais c'est en elle que nous devons vivre d'une manière ou d'une autre dans les années à venir. Il est donc nécessaire de développer un antidote contre ce type de bourrage.

Les conservateurs du dictionnaire Collins ont appelé le terme "fausses nouvelles" l'expression de 2017, soulignant ainsi que l'utilisateur moyen est accro au clickbate et republie les titres sensationnels sans perdre de temps à vérifier l'authenticité de l'information. Pendant ce temps, les fausses informations peuvent influer sur les résultats des élections et des référendums. Et cela fait également partie de la nouvelle réalité dans laquelle nous existons déjà et dans laquelle nous devrons apprendre à être moins frivoles.

Les réseaux sociaux ont déjà fait d’Internet une maison aux murs de verre où des millions de personnes peuvent regarder votre vie tous les jours, même lorsque vous ne le souhaitez pas. Il est maintenant évident qu’il n’ya pas de porte dans cette maison: tout le monde peut essayer d’envahir votre espace personnel, en utilisant l’IA pour vous défoncer le visage de pornorol ou du film «Le Seigneur des anneaux». La vie privée est morte, mais Big Brother est coupable de cela sous la forme de services spéciaux et d'entreprises mondiales, mais aussi de nous-mêmes.

Le monde des faux numériques arrive, mais ce n’est pas une raison pour la panique, la paranoïa, le refus d’utiliser Internet ou la nécessité d’interdire les réseaux de neurones. C’est une raison pour penser à l’hygiène des réseaux et à la nouvelle éthique, qui résoudront définitivement le fait qu’utiliser l’image de quelqu'un d’autre pour créer un faux numérique est vil et illégal. Les temps où les gens croyaient inconditionnellement tout ce qu'ils disaient à la télévision (même s'ils disaient que "Lénine était un champignon") s'effacent. De la même manière, nous nous habituons progressivement à ne plus croire tout ce qui est écrit sur Internet.

Couverture:Warp Records